La gestion factorielle révolutionne la gestion quantitative

Par Etienne Vincent, responsable des gestions quantitatives, et Charles Cresteil, spécialiste investissement, chez BNP Paribas Asset Management

Par Etienne Vincent, responsable des gestions quantitatives, et Charles Cresteil, spécialiste investissement, chez BNP Paribas Asset Management

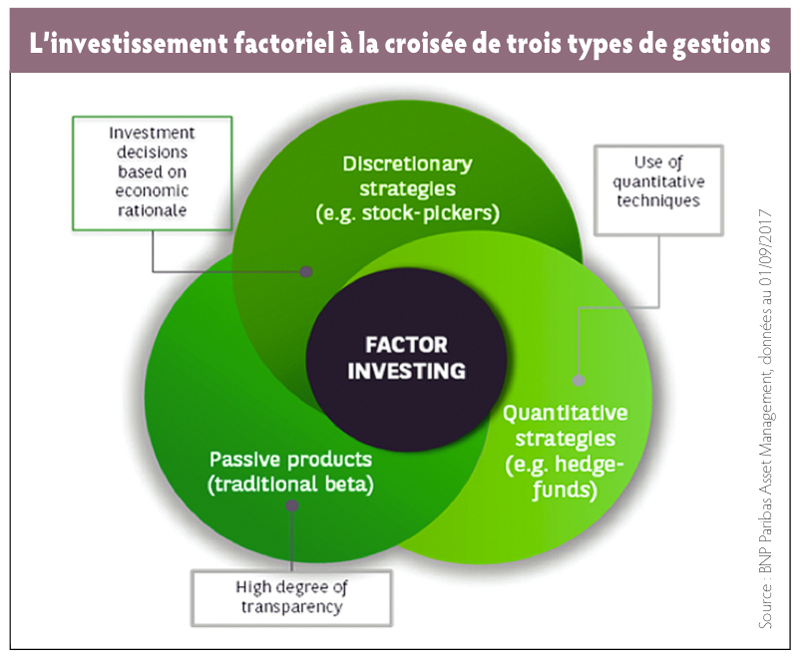

A mi-chemin entre les gestions quantitative, discrétionnaire et indicielle, la gestion factorielle s’impose de plus en plus dans les portefeuilles des investisseurs.

L’engouement marqué des investisseurs pour les stratégies dites factorielles (factor investing) ou plus généralement « smart beta » au cours des dernières années est largement commenté comme le retour en grâce des stratégies quantitatives, après une phase de méfiance faisant suite à la crise financière de 2007.

Pour mieux comprendre pourquoi et comment l’approche factorielle marque une évolution majeure de la gestion quantitative, il est utile de se pencher sur ses origines.

Les origines de la gestion quantitative

L’approche quantitative de l’investissement – que l’on peut définir schématiquement comme l’application de critères mathématiques ou statistiques issus de la recherche économique comme support des décisions d’investissement – trouve ses origines au début du XXe siècle. En 1900 déjà, Louis Bachelier étudie les fluctuations des prix des actions à l’aide de techniques statistiques. A cette époque, l’investissement quantitatif ne reste cependant qu’une discipline de recherche académique sans application dans le monde financier.

Il faut attendre la popularisation de la théorie moderne du portefeuille de Markowitz pour que la recherche de preuves de l’inefficience des marchés pose les bases de l’approche quantitative telle que nous la connaissons aujourd’hui. En effet, c’est en montrant l’existence d’anomalies à la théorie de Markowitz, c’est-à-dire en prouvant qu’il était possible de construire des portefeuilles dont la performance réalisée était supérieure à ce que leur risque supposait, que l’on comprit qu’il était possible de surperformer le marché en appliquant strictement des règles d’investissement prédéfinies (par exemple en privilégiant les titres des entreprises ayant le meilleur earnings yield).

C’est en s’appuyant sur ces concepts, parallèlement au développement de l’informatique et des bases de données financières, que les premières stratégies de gestion quantitative se développent dans les années 1980-1990. Les principales raisons de leur succès auprès des investisseurs sont la diversification qu’elles procurent – de par leur approche fondamentalement différente des autres approches de gestion –, ainsi que la performance « promise » par les simulations historiques (les backtests) qui permettent d’évaluer leur comportement supposé dans différentes conditions de marché.

La crise financière de 2007-2009 porte un sérieux coup d’arrêt à l’intérêt pour les techniques de gestion quantitatives, et ce pour différentes raisons. D’abord la diversification n’a pas résisté à la très puissante vague de re-corrélation observée pendant la crise, aussi bien entre les différentes classes d’actifs qu’entre les stratégies, notamment en raison du retrait massif de liquidités de la part des investisseurs pour aller vers des valeurs refuge. Ensuite, les promesses de performance entrevues dans les simulations historiques ne furent pas tenues dans ce contexte de marché exceptionnel, car les stratégies sélectionnées avaient souvent été choisies pour leur performance récente, dans des conditions de marché très différentes.

De manière plus générale enfin, la crise financière engendra – à juste titre – une plus grande méfiance envers les techniques d’investissement particulièrement complexes et/ou opaques. Près de dix ans après la crise, les stratégies quantitatives connaissent un intérêt important des investisseurs, sous une forme essentiellement nouvelle, celle de l’investissement factoriel.

La gestion factorielle : une gestion quantitative 2.0

La gestion factorielle : une gestion quantitative 2.0

Dans la mesure où ni le concept de facteurs, ni la gestion quantitative ne sont des thèmes nouveaux, on peut se demander en quoi le factor investing est une réelle innovation et non un simple « relooking » de stratégies déjà existantes. En réalité, il s’agit en fait d’une évolution majeure de l’approche quantitative et ce à plusieurs égards. D’abord, il est important de noter que si les concepts de facteurs tels que Value étaient bien identifiés par la recherche économique, une grande partie des stratégies de gestion quantitatives de première génération employaient une approche purement statistique (on parlait ainsi d’arbitrage statistique), reposant sur l’analyse de données de prix historiques. Ces « modèles prédictifs » étaient ainsi très sensibles à la fenêtre de données utilisée lors de la phase de recherche. L’approche de la gestion factorielle peut quant à elle être qualifiée de « quantamentale » : il ne s’agit pas de chercher à maximiser la performance immédiate à tout prix (ce qui conduit tôt ou tard à prendre des décisions d’investissement non rationnelles) mais plutôt de s’exposer à un nombre réduit de facteurs dont il est possible d’expliquer pourquoi ils sont des vecteurs des marchés sur le long terme.

C’est aussi le concept sous-tendant la gestion dite « fondamentale » : chercher les entreprises possédant de bons fondamentaux, c’est-à-dire présentant des valorisations peu élevées par rapport aux flux de trésorerie ou aux bénéfices, ou à leur valeur comptable (facteur Value) ; ayant le modèle économique le plus compétitif et dirigées par des équipes très compétentes (qualité), celles achetées « au bon moment », généralement lorsque la dynamique de cours s’améliore (momentum) ; ou encore celles ne faisant pas peser trop de risque sur la valorisation du portefeuille (faible risque).

L’approche quantitative factorielle se distingue ainsi par l’utilisation de facteurs persistants, c’est-à-dire de facteurs dont la recherche académique a démontré qu’ils étaient associés à un meilleur ratio rendement risque à long terme que les indices traditionnels. En se plaçant dans un horizon temporel plus long, les stratégies factorielles privilégient ainsi la robustesse à la maximisation de la performance. On choisira ainsi de rester exposé aux valeurs de qualité même dans l’hypothèse où elles sous-performeraient pendant plusieurs trimestres, pour la bonne raison que sa performance est prouvée sur le long terme, tandis qu’une stratégie agnostique visant exclusivement à maximiser la performance serait au contraire amenée à privilégier les valeurs de faible qualité. C’est également la raison pour laquelle une majorité de stratégies factorielles s’abstient de faire du factor timing, en préférant allouer des budgets de risque fixes à chaque facteur. Cela revient à dire qu’en l’absence de conviction sur quelle sera la performance future de chaque facteur, on privilégie une allocation diversifiée à chacun d’entre eux. En cela, l’approche factorielle vise ainsi une plus grande simplicité et transparence que les stratégies quantitatives traditionnelles.

Enfin, l’innovation majeure de la gestion factorielle ne réside pas tant dans le choix des facteurs, c’est-à-dire les critères prédéfinis choisis pour sélectionner les titres, mais dans la manière dont ils sont utilisés pour construire un portefeuille. En particulier, il est crucial de s’assurer qu’un facteur ne comporte pas de biais structurel caché qui explique en grande partie sa performance. Prenons l’exemple d’un facteur fondamental tel que le facteur qualité. Il est assez aisé de trouver des indicateurs pertinents pour juger de la qualité d’une entreprise (par exemple liés à la profitabilité ou aux flux de trésorerie), mais un point déterminant est de s’assurer que la sélection des titres ne pénalise pas structurellement un secteur ou un pays par rapport à un autre. Le risque serait alors que ce soit la performance sectorielle qui soit le premier moteur de la performance du facteur. Un autre exemple est celui du facteur momentum.

Ce facteur cherche à capter les tendances de marchés en surpondérant les titres qui ont le mieux performé sur une période récente et à sous-pondérer les moins performants. Une version naïve du facteur momentum, qui ne ferait que regarder la performance relative des titres serait systématiquement biaisée en termes de beta (ou de risque). En effet, en période de marché haussier, les titres à beta élevé surperforment naturellement les titres défensifs à beta plus faible, et inversement. On se retrouverait ainsi avec un portefeuille à haut beta après une période de marché haussier et un portefeuille défensif après une baisse. In fine, ce biais de beta serait le premier contributeur à la performance, alors que le principe même du facteur est différent, il s’agit d’identifier des titres qui, toutes choses étant égales par ailleurs, bénéficient d’une tendance favorable. Une version améliorée du facteur reposera ainsi sur la performance ajustée du beta pour éviter de n’être parasitée par ce biais. Cette approche, que l’on décrit de manière assez imparfaite comme la « purification » des facteurs, est cruciale pour assurer une meilleure robustesse au portefeuille final.

A la croisée des grandes approches de gestion

L’investissement factoriel constitue ainsi une évolution considérable de la gestion quantitative vers une approche plus fondamentale, plus transparente et plus robuste de la gestion quantitative. En cela, elle se positionne à la croisée entre trois grands types de gestion :

- la gestion quantitative pour le recours aux techniques quantitatives permettant d’appliquer les décisions d’investissement de manière disciplinée et objective ;

- la gestion discrétionnaire, pour l’utilisation d’indicateurs fondamentaux dont la performance peut être expliquée par des considérations économiques ;

- et la gestion indicielle pour la recherche de transparence et de capacité.

Des interrogations légitimes, mais exagérées

Face à la popularité de l’investissement factoriel, certaines voix s’élèvent cependant pour agiter des épouvantails, pointant notamment vers deux points d’inquiétude : la question de la persistance des facteurs et de l’encombrement (over-crowding) de ces stratégies par rapport à leur capacité supposée.

Selon certains observateurs ayant une vision assez cynique des marchés financiers, toute idée d’investissement est vouée à disparaître, soit par arbitrage (par des Hedge Funds ou d’autres grands « acteurs intelligents »), soit par un succès démesuré qui pénaliserait les performances et décevrait les investisseurs. Implicitement, une telle vision suppose que les marchés sont globalement rationnels, même si des exceptions et des déséquilibres peuvent créer ici et là des opportunités à court terme. Or le principe même de l’investissement factoriel est de s’exposer à des facteurs éprouvés sur le long terme. La recherche académique a ainsi fourni les preuves que ces primes existent depuis des décennies et dans des conditions de marché très différentes. A moins de remettre en question ces travaux, la conclusion qui s’impose est que les marchés ne sont pas parfaitement rationnels. Ainsi, parmi les explications le plus souvent avancées par la recherche académique pour justifier la performance des facteurs, un grand nombre repose sur l’existence de biais émotionnels chez les investisseurs qui impactent leurs décisions.

En effet, s’il doit identifier des opportunités sur des univers d’investissement de plusieurs centaines ou milliers de titres, un investisseur humain risque fortement d’introduire une dose de subjectivité dans ses choix, par exemple en privilégiant les titres qu’il connaît le mieux (biais de familiarité) ou en mettant du temps à changer d’avis sur une valeur malgré de nouvelles informations (biais de conservatisme). C’est la persistance de ces biais émotionnels – a priori inhérents au processus de décision humain – qui garantit la persistance des facteurs. L’objection suivante, selon laquelle l’investissement factoriel pourrait devenir victime de son succès, les biais émotionnels des marchés disparaissant à mesure que les flux dans les stratégies factorielles augmentent, souffre quant à elle de deux idées fausses. D’abord, même dans les hypothèses les plus optimistes, la taille du marché « Smart Beta » n’atteindrait pas 10 % de l’industrie mondiale de la gestion d’actifs avant encore des décennies, tandis que l’indexation par capitalisation boursière dépasse 50 % dès aujourd’hui, quelle que soit la mesure utilisée. Dans certains marchés financiers, comme les actions émergentes, les indices par capitalisation boursière sont précisément les plus demandés. D’autre part, quand bien même les encours de la gestion factorielle dépasseraient-ils les projections les plus optimistes, il faut noter qu’il existe aujourd’hui une grande diversité dans les approches factorielles. En effet, même si les facteurs utilisés sont généralement communs entre différentes stratégies, les méthodologies de construction de portefeuille et de calibration des risques tendent à produire des portefeuilles largement différents, notamment lorsqu’elles sont employées sur des univers d’investissement très larges. Enfin, en employant une approche de recherche de performance à long terme, la gestion factorielle se différencie du « court-termisme » dont ont pu faire preuve les stratégies quantitatives de première génération accentuant de fait certaines distorsions des marchés jusqu’à créer des bulles. Toutefois, cela ne signifie en rien que la croissance phénoménale des encours dans les stratégies « Smart Beta » ne pose aucun problème. Certaines stratégies par exemple font largement appel aux actions illiquides ou de plus petite capitalisation. Si ces stratégies n’intègrent pas des hypothèses de coûts de transactions réalistes, leur développement risque fort de se faire au détriment de la performance. En outre, le darwinisme du monde de l’investissement (ou « l’effet winner takes all ») pourrait engendrer une concentration des flux de capitaux vers un nombre limité de produits, pesant sensiblement sur la plus-value à court terme des gérants de ces stratégies. Pour mitiger ces risques, il est donc essentiel de veiller à diversifier son exposition sur différentes stratégies factorielles et de privilégier les stratégies les plus robustes mises en place sur des univers d’investissement suffisamment larges.

La gestion factorielle se présente comme une évolution majeure de la gestion quantitative, tirant les enseignements des faiblesses des stratégies quantitatives de première génération pour faire le lien avec la gestion active traditionnelle vers une approche « quantamentale » plus fondamentale, transparente et rationnelle de l’investissement. A une époque où la mondialisation des marchés et l’explosion de la quantité d’information disponible ont démultiplié les opportunités d’investissement, et où les investisseurs demandent plus de transparence sur l’origine de la performance et du risque dans leur portefeuille, toutes les conditions semblent réunies pour que le succès de la gestion quantitative factorielle se confirme, mais il faudra pour cela qu’elle reste fidèle aux principes qui l’ont porté à naître : s’appuyer sur des facteurs explicables, éprouvés sur le long terme et sur un processus d’investissement robuste et transparent.

Vos réactions